Le chat Felo AI prend désormais en charge l'utilisation gratuite du modèle d'inférence O1

Dans le domaine en plein développement de l’intelligence artificielle,OpenAI lance une série de modèles de langage révolutionnaires,Appelé série o1。Ces modèles sont conçus pour effectuer des tâches d'inférence complexes,Ce qui en fait un outil puissant pour les développeurs et les chercheurs。Dans cet article de blog,Nous explorerons comment utiliser efficacement les modèles d'inférence d'OpenAI,Concentrez-vous sur leurs capacités、Limites et bonnes pratiques de mise en œuvre。

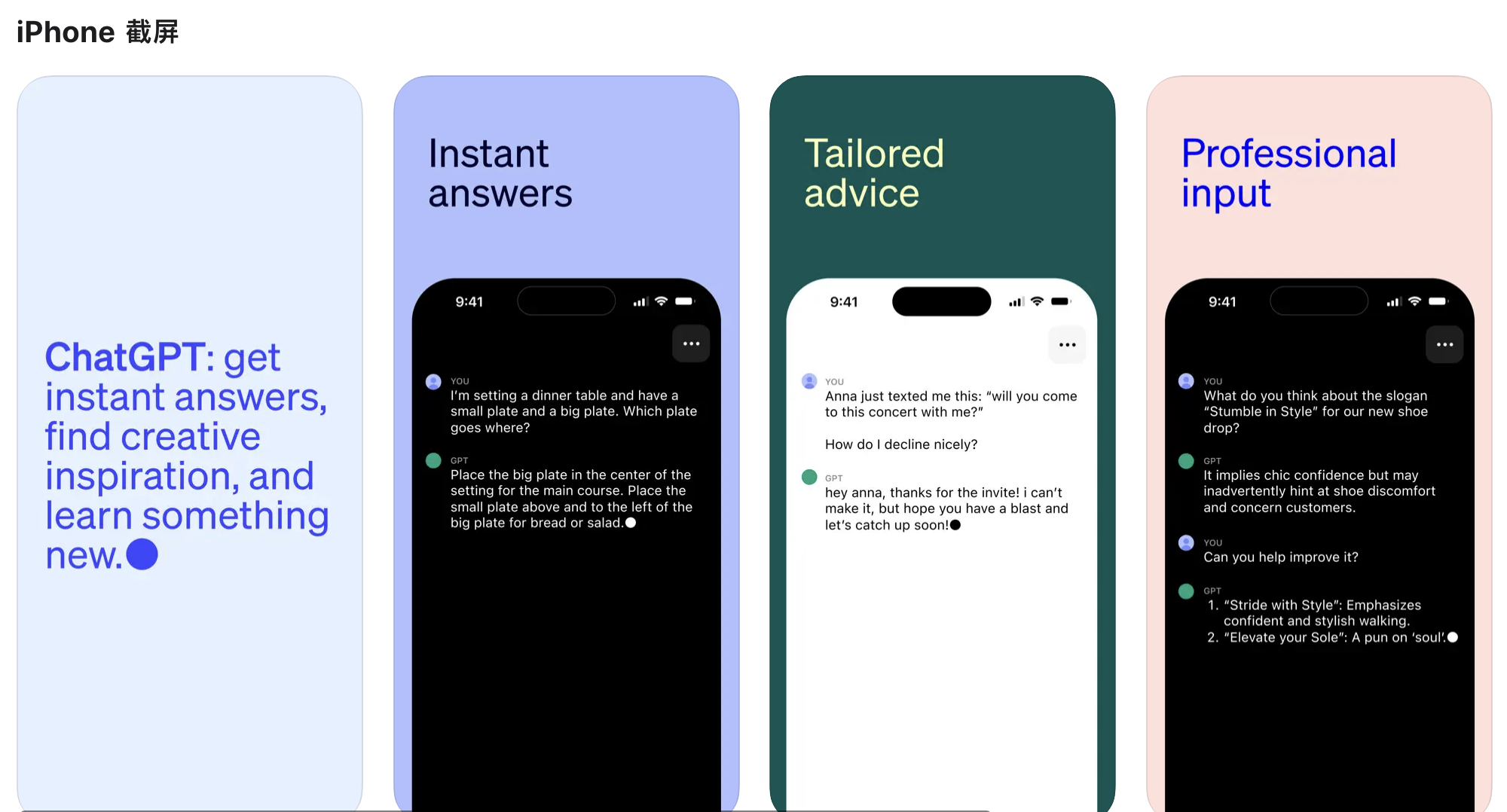

Felo AI Chat prend désormais en charge l'utilisation gratuite des modèles d'inférence O1。Venez l'essayer!

Comprendre les modèles de la série OpenAI o1

Le modèle de la série o1 est différent des itérations précédentes du modèle de langage d'OpenAI,Principalement en raison de sa méthode de formation unique。Ils utilisent l'apprentissage par renforcement pour améliorer leurs capacités de raisonnement,leur permettre de réfléchir de manière critique avant de générer une réponse。Ce processus de réflexion interne permet au modèle de générer de longues chaînes de raisonnement,Ceci est particulièrement bénéfique pour résoudre des problèmes complexes。

Principales fonctionnalités du modèle OpenAI o1

1. **raisonnement avancé**:Le modèle o1 excelle dans le raisonnement scientifique,A obtenu des résultats impressionnants sur les programmes compétitifs et les références académiques。Par exemple,Ils se classent dans le 89ème centile sur Codeforces,et en physique、Démontrer une précision de niveau doctorat dans des matières telles que la biologie et la chimie。

2. **deux variantes**:OpenAI propose deux versions du modèle o1 via son API:

– **o1-aperçu**:Ceci est une première version,Vise à faire preuve de bon sens pour résoudre des problèmes difficiles。

– **o1-mini**:Une variante plus rapide et plus rentable,Particulièrement adapté au codage qui ne nécessite pas beaucoup de bon sens、tâches de mathématiques et de sciences。

3. **fenêtre contextuelle**:Le modèle o1 possède une fenêtre contextuelle importante de 128 000 marqueurs,Permet un large éventail de contributions et de raisonnements。Cependant,Il est crucial de bien gérer ce contexte pour éviter d’atteindre la limite de tags。

Commencez avec le modèle OpenAI o1

Pour commencer à utiliser le modèle o1,Les développeurs peuvent y accéder via le point de terminaison de discussion de l'API OpenAI.。

Êtes-vous prêt à améliorer votre expérience interactive avec l’IA ? Felo AI Chat offre désormais la possibilité d'explorer des modèles d'inférence O1 de pointe,Totalement gratuit !

Essai gratuit du modèle d'inférence o1。

Limites bêta du modèle OpenAI o1

Il convient de noter que,Le modèle o1 est actuellement en phase de test,Cela signifie qu'il y a certaines limites à prendre en compte:

en phase de test,De nombreux paramètres de l'API de complétion de chat ne sont pas encore disponibles。notamment:

- modal:Ne prend en charge que le texte,Image non prise en charge。

- Type de message:Prend uniquement en charge les messages des utilisateurs et des assistants,Les messages système ne sont pas pris en charge。

- streaming:Non pris en charge。

- outil:Outils non pris en charge、Paramètres de format d’appel de fonction et de réponse。

- Problèmes de journalisation:Non pris en charge。

- autre:

temperature、top_petnfixé à1,etpresence_penaltyetfrequency_penaltyfixé à0。 - Aides et traitement par lots:Ces modèles ne sont pas pris en charge pour une utilisation dans l'API d'assistance ou l'API par lots。

**Gérer la fenêtre contextuelle**:

Puisque la fenêtre contextuelle est de 128 000 points,L’espace doit être géré efficacement。Chaque complétion a une limite maximale de balises de sortie,Comprend des marqueurs d'inférence et d'achèvement visibles。Par exemple:

– **o1-aperçu**:Jusqu'à 32 768 marqueurs

– **o1-mini**:Jusqu'à 65 536 marqueurs

Vitesse du modèle OpenAI o1

Pour illustrer ce point,Nous avons comparé GPT-4o、Réponses o1-mini et o1-preview à une question de raisonnement de mots。Bien que GPT-4o fournisse la mauvaise réponse,Mais o1-mini et o1-preview ont répondu correctement,La bonne réponse de o1-mini est environ 3 à 5 fois plus rapide。

Comment utiliser GPT-4o、Choisir entre les modèles o1-Mini et o1-Preview ?

**Aperçu O1**:Il s'agit d'une première version du modèle OpenAI O1,Vise à utiliser le bon sens pour raisonner sur des problèmes complexes。

**O1Mini**:Une version plus rapide et plus abordable d'O1,Particulièrement bon en codage、tâches de mathématiques et de sciences,Convient aux situations où un bon bon sens n'est pas requis。

Le modèle O1 apporte des améliorations significatives en matière d'inférence,Mais il n’est pas destiné à remplacer GPT-4o dans tous les cas d’utilisation。

Pour la saisie d'image requise、appel de fonction ouApplications avec des temps de réponse toujours rapides,Les modèles GPT-4o et GPT-4o Mini restent les meilleures options。Cependant,Si vous développez une application qui nécessite une inférence profonde et peut tolérer de longs temps de réponse,Le modèle O1 pourrait être un bon choix。

Conseils pour des astuces efficaces pour les modèles o1-Mini et o1-Preview

Les modèles OpenAI o1 fonctionnent mieux lorsqu'ils utilisent des indices clairs et directs。quelques techniques,Par exemple, un petit nombre d'exemples invitent ou demandent au modèle de « penser étape par étape »,Peut ne pas améliorer les performances,Cela peut même nuire aux performances。Voici quelques bonnes pratiques:

1. **Gardez les conseils simples et directs**:Lorsque le modèle reçoit le brief、instructions claires,meilleur effet,sans élaboration approfondie。

2. **Conseils pour éviter la pensée en chaîne**:Puisque ces modèles gèrent l’inférence en interne,Il n’est donc pas nécessaire de les inciter à « réfléchir étape par étape » ou à « expliquer votre raisonnement ».。

3. **Utilisez des délimiteurs pour plus de clarté**:Utiliser des guillemets triples、Des délimiteurs tels que des balises XML ou des titres de section pour définir clairement les différentes parties de l'entrée,Cela aide le modèle à interpréter correctement chaque partie。

4. **Limiter le contexte supplémentaire dans la génération d'augmentation de récupération (RAG)**:Lorsque vous fournissez un contexte ou une documentation supplémentaire,Incluez uniquement les informations les plus pertinentes,pour éviter de trop compliquer la réponse du modèle。

Prix des modèles o1-Mini et o1-Preview。

Les modèles o1 Mini et o1 Preview ont un coût différent de celui des autres modèles,Parce qu'il inclut le coût supplémentaire du marquage inférentiel。

Tarifs o1-mini

$3.00 / 1Marque d'entrée M

$12.00 / 1Indicateur de sortie M

Tarifs o1-preview

$15.00 / 1Marque d'entrée M

$60.00 / 1Indicateur de sortie M

Gérer les coûts des modèles o1-preview/o1-mini

Afin de contrôler le coût des modèles de la série o1,Vous pouvez définir une limite sur le nombre total de jetons générés par le modèle à l'aide du paramètre `max_completion_tokens`,Comprend les notes d'inférence et d'achèvement。

dans les premiers modèles,Le paramètre `max_tokens` gère le nombre de tokens générés et le nombre de tokens visibles par l'utilisateur,Les deux sont toujours les mêmes。Cependant,En série o1,Marqué en raison d'un raisonnement interne,Le nombre total de balises générées peut dépasser le nombre de balises affichées par l'utilisateur。

Étant donné que certaines applications s'appuient sur « max_tokens » correspondant au nombre de jetons reçus de l'API,La série o1 a introduit `max_completion_tokens`,Pour contrôler spécifiquement le nombre total de jetons générés par le modèle,Comprend des marqueurs d'inférence et d'achèvement visibles。Ce choix clair garantit que les applications existantes restent compatibles avec le nouveau modèle。Le paramètre `max_tokens` continue de fonctionner comme tous les modèles précédents。

en conclusion

La série de modèles o1 d’OpenAI représente une avancée majeure dans l’intelligence artificielle,Notamment en termes de capacité à effectuer des tâches de raisonnement complexes。En comprenant leurs capacités、Limites et bonnes pratiques d'utilisation,Les développeurs peuvent exploiter la puissance de ces modèles pour créer des applications innovantes。Alors qu'OpenAI continue d'affiner et d'étendre la série o1,Nous pouvons nous attendre à des développements plus passionnants dans le domaine de l’inférence basée sur l’IA.。Que vous soyez un développeur expérimenté ou débutant,Les modèles o1 offrent tous des opportunités uniques pour explorer l'avenir des systèmes intelligents。Bon codage !

Young AI Chat始终为您提供来自世界各地的先进AI模型的免费体验。Cliquez ici pour l'essayer!

.webp)

Pas encore de commentaires